Flux.2 Max 现已正式发布

Flux 2 Max 是 Flux 2 系列中最先进的版本,专为追求高精度、真实感和生产级视觉输出的创作者而设计。作为一款高端的 AI 图像生成器(AI Image Generator) 与强大的 AI 图像编辑器(AI Image Editor) 的结合体,Flux 2 Max 将图像质量与一致性提升到了全新高度,非常适合专业级创作流程。

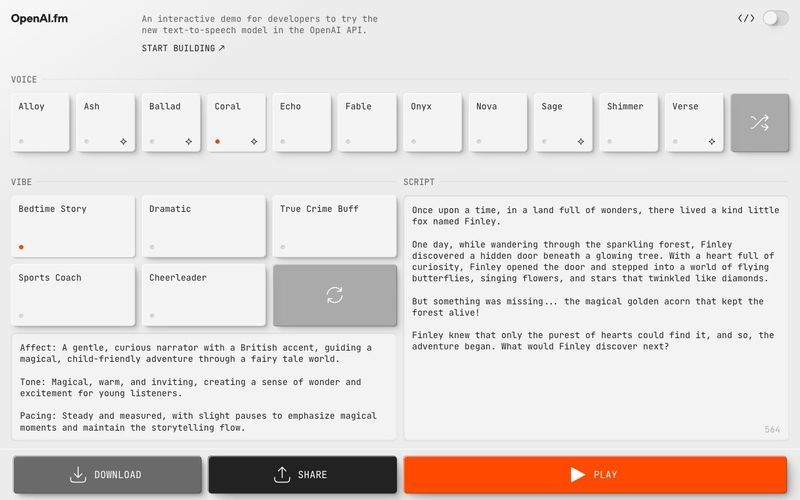

用于转录或生成音频的 API 主要包括:

API支持的模式流式支持Realtime API音频和文本输入输出支持音频流式输入和输出Chat Completions API音频和文本输入输出支持音频流式输出Transcription API音频输入支持音频流式输出Speech API文本输入和音频输出支持音频流式输出

主要区别在于通用 API 和专用 API。使用 Realtime 和 Chat Completions API,您可以利用最新模型的音频理解和生成能力,并结合其他功能(如函数调用)。这些 API 适用于广泛的使用场景,且您可以选择不同的模型。

另一方面,Transcription、Translation 和 Speech API 仅限于特定的任务,例如语音转录、翻译或语音合成。

选择合适 API 的另一种方式是考虑您需要多少控制权。如果您希望设计对话交互,即模型能够思考并用语音响应,可以使用 Realtime 或 Chat Completions API,具体取决于您是否需要低延迟。

使用这些 API,您无法提前确定模型的具体回答,但能提供更自然的交互体验。

如果您希望更多控制和可预测性,可以使用语音到文本 / LLM / 文本到语音的模式,以确保模型输出可控,但会增加一定的延迟。

Audio API 适用于此类场景:结合 LLM 与 audio/transcriptions 和 audio/speech 端点,接收用户语音输入,处理生成文本响应,再转换为语音输出。

如果需要 实时交互 或 转录功能,请使用 Realtime API。

如果实时性不是必须,但希望构建 语音代理 或支持 函数调用 的音频应用,请使用 Chat Completions API。

如果仅需特定用途,请使用 Transcription、Translation 或 Speech API。

GPT-4o 和 GPT-4o mini 等模型原生支持多模态输入输出,即可以理解和生成多种格式的数据。

如果您的应用当前使用 Chat Completions 端点进行文本交互,可考虑添加音频功能。例如,如果您的聊天应用支持文本输入,可以增加音频输入和输出——只需在 modalities 数组中包含 audio 并使用音频模型,如 gpt-4o-audio-preview。

Flux 2 Max 是 Flux 2 系列中最先进的版本,专为追求高精度、真实感和生产级视觉输出的创作者而设计。作为一款高端的 AI 图像生成器(AI Image Generator) 与强大的 AI 图像编辑器(AI Image Editor) 的结合体,Flux 2 Max 将图像质量与一致性提升到了全新高度,非常适合专业级创作流程。

随着人工智能的飞速发展,11月成为了全年最具突破性的月份之一。从新一代图像模型和令人惊叹的视频工具,到能够编写代码、构建应用程序、清理杂乱数据,甚至从零开始创建完整学习中心的 AI 助手,应有尽有。无论你是创作者、营销人员、学生、开发者,还是仅仅是一位人工智能爱好者,本月的种种新发现都会让你重新思考人工智能的无限可能。

2025年最佳AI大模型与AI工具,最受欢迎的免费AI大模型与AI工具。

探索10个强大的AI写作工具,它们将彻底改变你的内容营销工作流程。从演示文稿到文章,这些工具可以帮助你高效创建引人入胜的内容。